1.环境说明

1 | |

2.源码安装

1.1、获取tar包

1 | |

1.2、上传tar包,解压改名

1 | |

1.3、修改zookeeper配置

1 | |

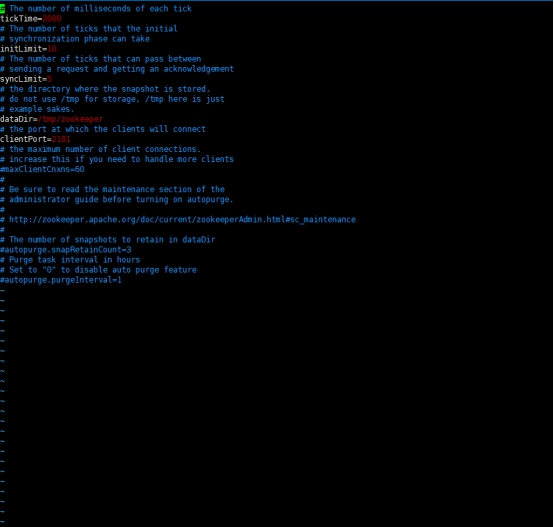

默认配置如下:

修改配置如下:

1 | |

最后使用wq!保存修改,说明:

dataDir 和 dataLogDir 需要在启动前创建完成

clientPort 为 zookeeper的服务端口

server.0、server.1、server.2 为 zk 集群中三个 node 的信息,定义格式为 hostname:port1:port2,其中 port1 是 node 间通信使用的端口,port2 是node 选举使用的端口,需确保三台主机的这两个端口都是互通的。

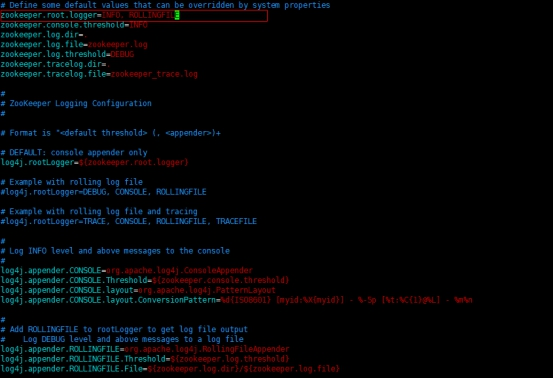

1.4、更改日志配置

1 | |

1.5、同上操作,在另外的机器也是如此操作

1.6、创建 myid 文件

1 | |

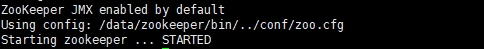

1.7、启动服务,默认后台启动

1 | |

返回信息:

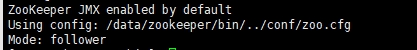

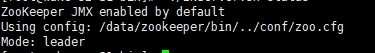

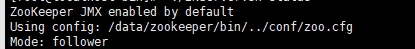

1.8、查看集群状态

节点启动完成后,可依次执行如下命令查看集群状态:

1 | |

可以看到三台已经选举成功:

ZkUI部署文档

1. 源码安装

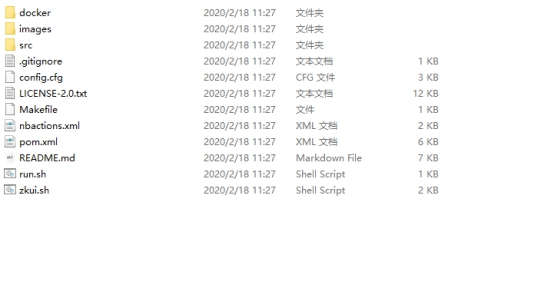

1.1、下载源码

1 | |

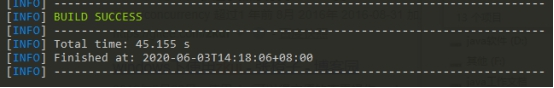

1.2、Maven打包

1 | |

打包成功后在target目录下可以看到如下zkui-2.0-SNAPSHOT-jar-with-dependencies.jar,这个正是我们需要的jar包

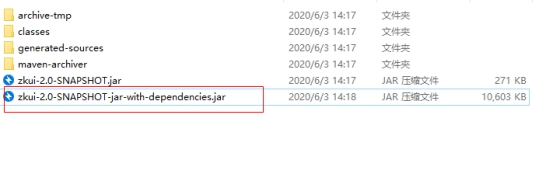

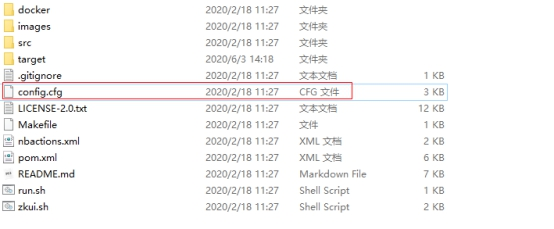

1.3、上传jar包和配置文件cfg到服务器

配置文件位置在项目文件的根目录下,如下图所示:

1 | |

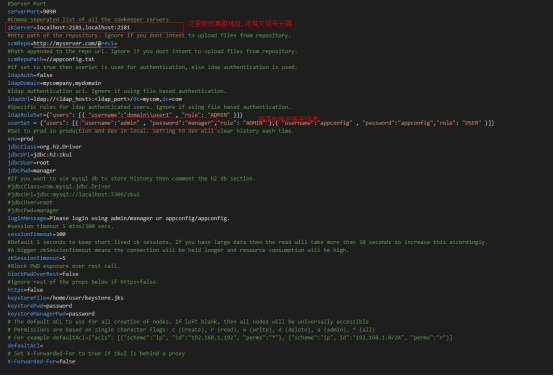

2. 修改配置

1 | |

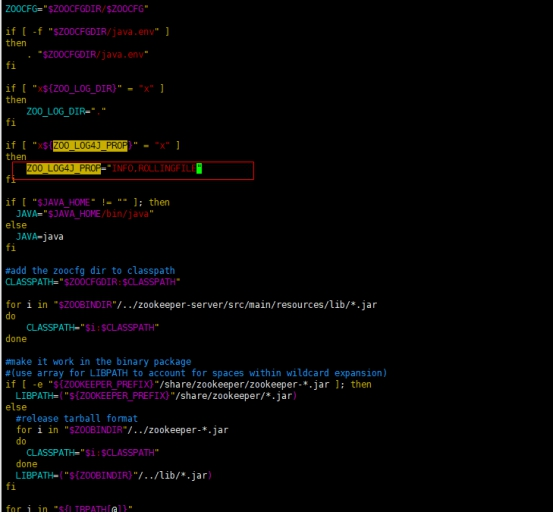

3. 启动服务

放入启动脚本zkui_start.sh:

1 | |

使用脚本启动:

1 | |

停止命令参考:

1 | |

检测是否启动成功:

1 | |

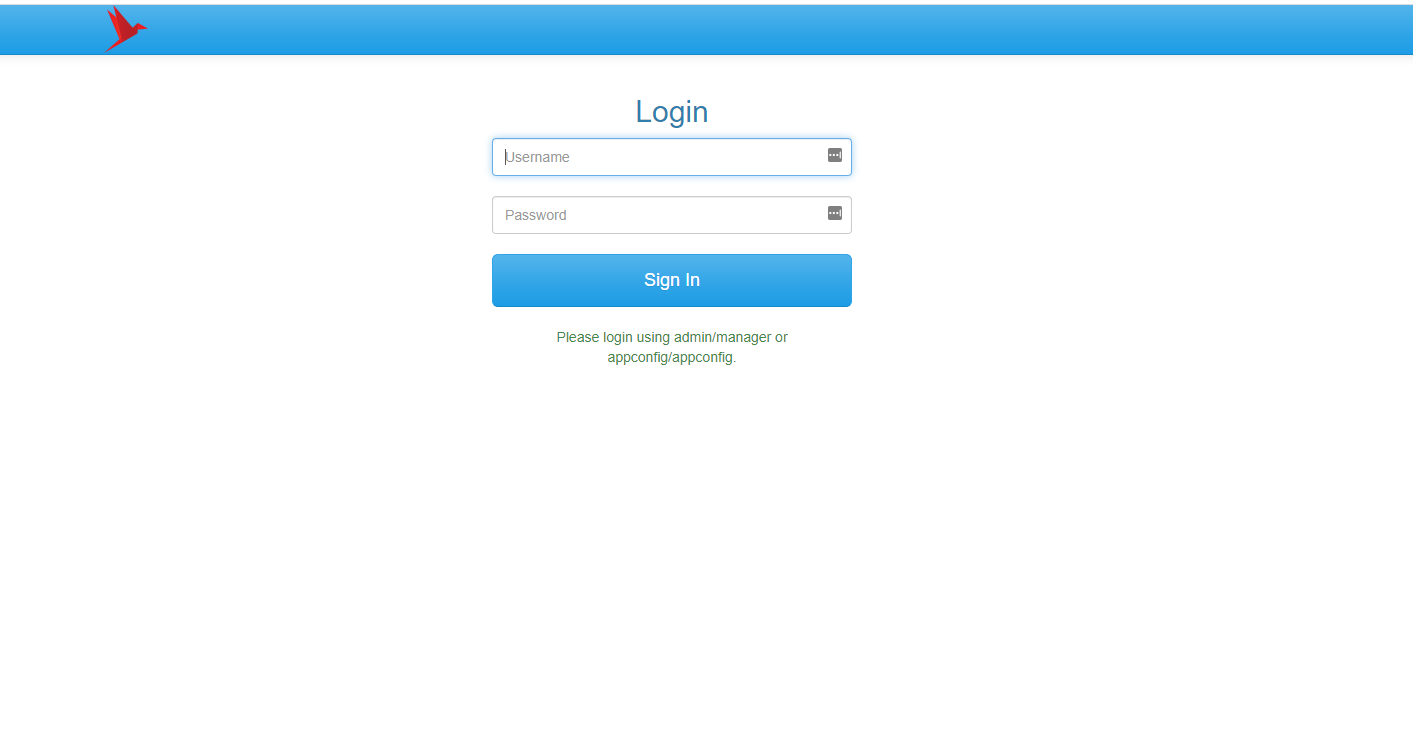

4. 界面相关

启动完成后访问:

http://192.168.2.128:9090/

输入我们配置中的账密,默认是:

1 | |

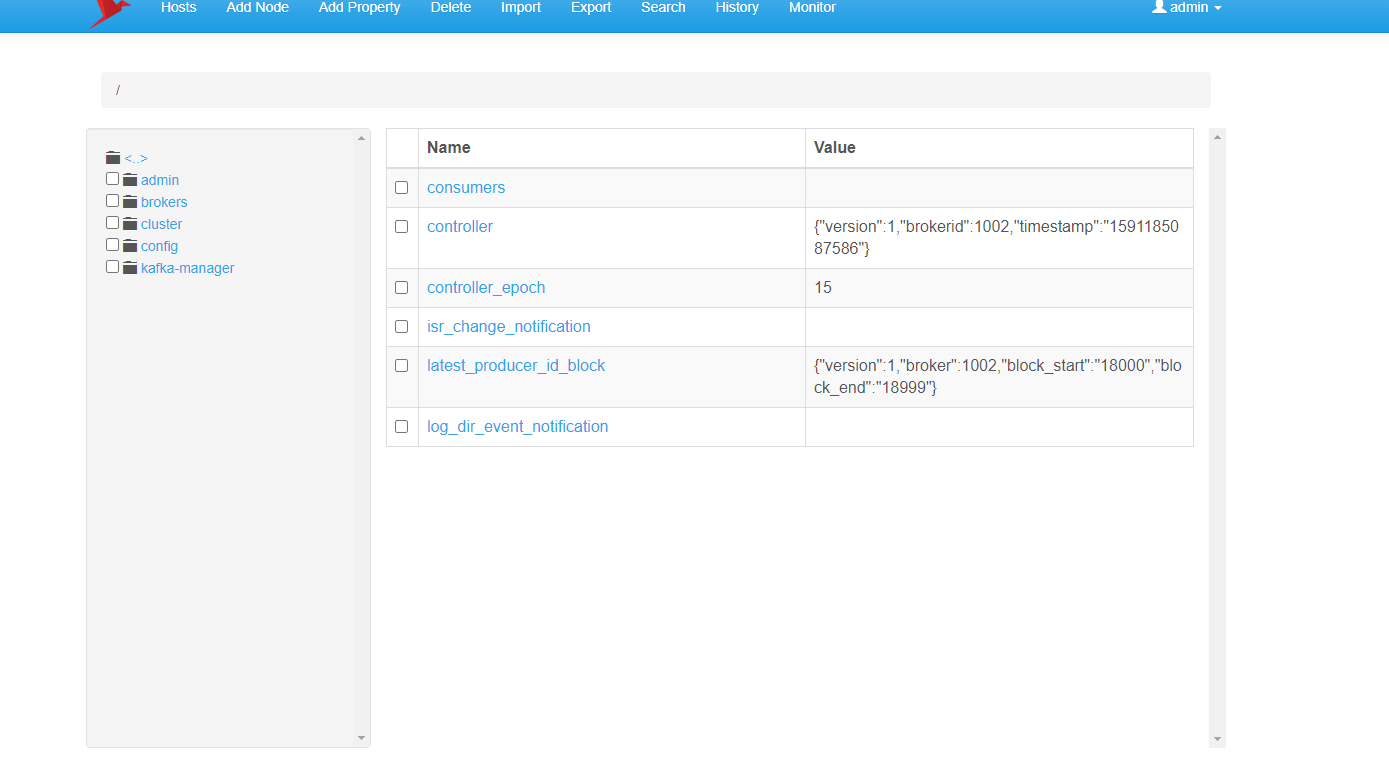

查看节点信息界面:

查看集群状态:

5. 配置开机自启

1.1、在 /lib/systemd/system/ 目录下创建 zookeeper.service 的配置文件

1 | |

zookeeper.service 添加内容:

1 | |

注:以上文件 根据自己的 jdk 和 kafka 安装目录相应的修改。

1.2、刷新配置

1 | |

1.3、zookeeper服务加入开机自启

1 | |

1.4、使用systemctl启动/关闭/重启 zookeeper服务

1 | |

1.5、查看状态

1 | |